Yapay zeka alanındaki donanım yarışı, yeni nesil bellek teknolojilerinde de kendini gösteriyor. Nvidia ve AMD, 2026 yılında piyasaya sürmeyi planladıkları yeni yapay zeka hızlandırıcılarında yalnızca HBM4 (High Bandwidth Memory 4) belleğini kullanmakla kalmayacak, aynı zamanda bu belleği özelleştirerek performans çıtasını daha da yukarı taşıyacak.

HBM4 bellekler yakında karşımıza çıkıyor

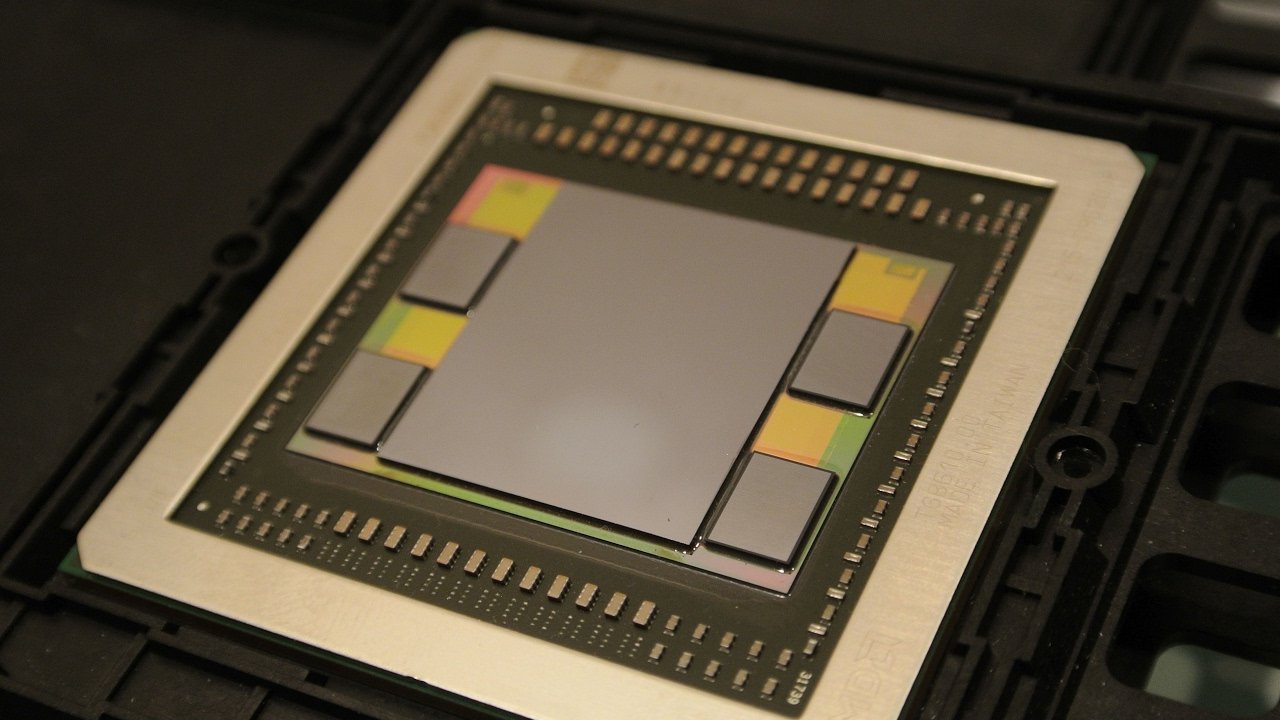

HBM, dikey olarak üst üste yerleştirilmiş DRAM katmanlarından oluşan bir bellek yapısı. Bu katmanlar, TSV (Through-Silicon Via) adı verilen bağlantılarla birbirine bağlanıyor. Bu sayede hem bant genişliği artıyor hem de enerji verimliliği sağlanıyor. Genellikle 12 katmana kadar çıkabilen bu yapının en alt katmanına özel bir mantık devresi eklenebiliyor.

Nvidia ve AMD, bu özelliği aktif olarak kullanarak bellekleri yalnızca veri depolayan yapılar olmaktan çıkarıp, veri yönlendirme süreçlerinde akıllı işlevler üstlenecek modüller hâline getirmeye hazırlanıyor.

Yapılan bu özelleştirmelerin temel amacı, mevcut performans sınırlarını aşmak ve özel amaçlı ASIC çözümlere karşı üstünlük sağlamak. Özellikle Google, Amazon ve Meta gibi şirketlerin kendi iç donanımlarında tercih ettiği ASIC hızlandırıcılar karşısında Nvidia ve AMD’nin rekabet gücünü koruması için, HBM belleklerin standart versiyonlarının ötesine geçmesi gerekiyor.

Gelen bilgilere göre, bu özel HBM4 çözümleri ilk olarak Nvidia’nın “Rubin” mimarisinde ve AMD’nin Instinct MI400 serisinde yer alacak. Her iki mimari de mevcut GPU hızlandırıcı tasarımlarını önemli ölçüde geride bırakması beklenen yeni nesil ürünler olacak.

Rubin, Nvidia’nın şu an piyasada yer alan Blackwell mimarisinin halefi olurken; MI400, AMD’nin raf düzeyinde ilk kez uygulanacak yapay zeka hızlandırıcı serisi olacak. Genellikle Micron, Samsung ve SK Hynix gibi üreticilerden alınan standart HBM belleklerin aksine, bu özelleştirilmiş versiyonlar doğrudan Nvidia ve AMD’nin taleplerine göre şekilleniyor.